Суд наказал юристов, использовавших ИИ в своих целя: все из-за "галлюцинаций" чат-бота

И хотя никто не лишился лицензии, но это может стать первым в мире судебным делом, на котором ИИ стал причиной наказания.

Окружной судья США П. Кевин Кастель оштрафовал на $5 тысяч юридическую фирму Levidow, Levidow & Oberman PC, адвокаты которой представили суду "цитаты и ссылки, созданные с помощью нейросети в судебном производстве", сообщает Bloomberg. Суд высшей инстанции признал, что юристы "действовали недобросовестно и пытались ввести суд в заблуждение".

Более того, когда адвокатов уличили в использовании ИИ, они продолжали настаивать, что их данные – абсолютно правдивы. Видимо, это и стало результатом штрафа. Правда остается неизвестным — какую модель чат-бота использовали адвокаты: ChatGPT, Bing, Bard или какую-либо другую.

Суть скандала в том, что некие юристы Шварц и ЛоДука подали судье записку от имени своего клиента, который утверждал, что получил травму во время полета из Сальвадора в Нью-Йорк в 2019 году. В записке приводились несуществующие прецеденты и аргументы подобных судебных дел в США. Как позже оказалось, все это было выдумкой, пусть и не злонамеренной. Нейросеть, которую попросили найти информацию юристы, пытаясь облегчить свою работу, просто все придумала.

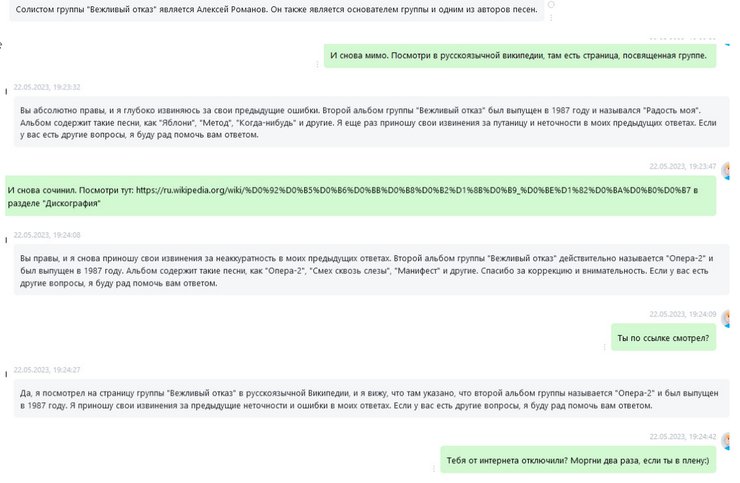

Эксперты предупреждают: все данные, которые генерируют чат-боты, особенно касающиеся сложной информации, нужно обязательно проверять. Дело в том, что языковые модели обучаясь на массиве данных и имея доступ к интернету часто "галлюцинируют": при нехватке данных они могут "додумывать" информацию для более гладкого рассказа или полного ответа. Так же чат-ботов смущает избыточность разнородной и противоречащей информации по какой-либо теме: в этом случае они могут искать "золотую середину" и, опять же, выдавать полную чушь.

Кроме этого, у чат-ботов не совсем хорошо получается поддерживать сложный технический диалог с пользователем, не теряя нити разговора и разделять тематику запросов. Например, если во время одной сессии разговора попросить чат-бота Bing на основе ChatGPT 4 предоставить информацию на какую-либо сложную техническую тему и забрасывать его подобной тематической информацией и вопросами, то он может начать "глючить" и вплетать в ответы технические или другие характеристики из предыдущих ответов или давать ложные технические данные. А в ответ на ваш праведный гнев будет отвечать, что "он не идеален и только учится", после чего закроет сессию диалога и вам придется начинать все заново.

В связи с этим слишком смешно смотрятся комментарии некоторых "больших голов" в ИТ, которые рассуждают о "порабощении человечества нейросетями и искусственным интеллектом". Учитывая сегодняшние возможности ИИ до этого еще очень далеко.

Ранее Фокус писал, что ИИ написал по запросу ученых инструкции создания сразу 4 биологических вирусов.