Суд покарав юристів, які використовували ШІ у своїх цілях: усе через "галюцинації" чат-бота

І хоча ніхто не позбувся ліцензії, але це може стати першою у світі судовою справою, на якій ШІ став причиною покарання.

Окружний суддя США П. Кевін Кастель оштрафував на $5 тисяч юридичну фірму Levidow, Levidow & Oberman PC, адвокати якої надали суду "цитати і посилання, створені за допомогою нейромережі в судовому провадженні", повідомляє Bloomberg. Суд вищої інстанції визнав, що юристи "діяли недобросовісно і намагалися ввести суд в оману".

Ба більше, коли адвокатів викрили у використанні ШІ, вони продовжували наполягати, що їхні дані — абсолютно правдиві. Мабуть, це і стало результатом штрафу. Щоправда, залишається невідомим — яку модель чат-бота використовували адвокати: ChatGPT, Bing, Bard або будь-яку іншу.

Суть скандалу в тому, що якісь юристи Шварц і ЛоДука подали судді записку від імені свого клієнта, який стверджував, що дістав травму під час польоту із Сальвадору до Нью-Йорка у 2019 році. У записці наводилися неіснуючі прецеденти й аргументи подібних судових справ у США. Як пізніше виявилося, все це було вигадкою, нехай і не зловмисною. Нейромережа, яку попросили знайти інформацію юристи, намагаючись полегшити свою роботу, просто все придумала.

Експерти попереджають: усі дані, які генерують чат-боти, особливо ті, що стосуються складної інформації, потрібно обов'язково перевіряти. Річ у тім, що мовні моделі, навчаючись на масиві даних і маючи доступ до інтернету, часто "галюцинують": за нестачі даних вони можуть "додумувати" інформацію для більш гладкої розповіді або повної відповіді. Так само чат-ботів бентежить надлишковість різнорідної та суперечливої інформації з якоїсь теми: у цьому разі вони можуть шукати "золоту середину" і, знову ж таки, видавати повну нісенітницю.

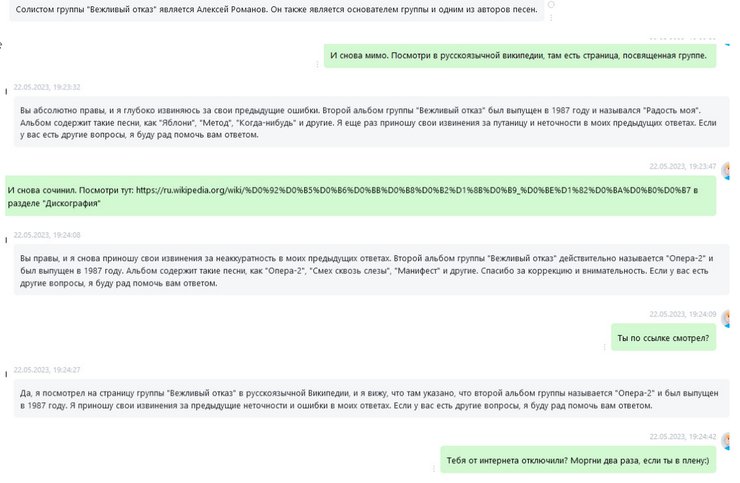

Крім цього, у чат-ботів не зовсім добре виходить підтримувати складний технічний діалог з користувачем, не втрачаючи сенсу розмови та розділяти тематику запитів. Наприклад, якщо під час однієї сесії розмови попросити чат-бота Bing на основі ChatGPT 4 надати інформацію на будь-яку складну технічну тему та закидати його подібною тематичною інформацією і запитаннями, то він може почати "глючити" і вплітати у відповіді технічні або інші характеристики з попередніх відповідей або давати неправдиві технічні дані. А у відповідь на ваш праведний гнів відповідатиме, що "він не ідеальний і тільки вчиться", після чого закриє сесію діалогу і вам доведеться починати все наново.

У зв'язку з цим надто смішно виглядають коментарі деяких "великих голів" в ІТ, які розмірковують про "поневолення людства нейромережами та штучним інтелектом". З огляду на сьогоднішні можливості ШІ до цього ще дуже далеко.

Раніше Фокус писав, що ШІ написав за запитом учених інструкції створення відразу 4 біологічних вірусів.