Искусственный интеллект Facebook назвал "приматами" чернокожих мужчин на видео

В компании назвали случившееся "недопустимой ошибкой" и пообещали пересмотреть работу механизма рекомендаций.

Компания Facebook извинилась перед пользователями своей соцсети за неправильную маркировку видео. Ранее пользователи, которые просматривали одно из видео с участием чернокожих мужчин, видели автоматическую подсказку социальной сети, в которой спрашивалось, хотят ли они "продолжать смотреть видео о приматах". Об этом сообщила газета The New York Times (NYT).

В компании назвали это "недопустимой ошибкой" и сказали, что изучает функцию рекомендаций, чтобы "предотвратить повторение подобного".

Видео, ставшее причиной скандала, датировано 27 июня 2020 года. Оно было опубликовано The Daily Mail и на нем показаны стычки чернокожих мужчин с белыми гражданскими лицами и полицейскими.

Дани Левер, пресс-секретарь Facebook, заявила: "Хотя мы и внесли улучшения в наш искусственный интеллект, мы знаем, что он не идеален, и нам еще предстоит продвинуться вперед. Мы приносим свои извинения всем, кто, возможно, видел эти оскорбительные рекомендации".

NYT напоминает, что Google, Amazon и другие технологические компании в течение многих лет подвергались тщательной проверке на предмет предвзятости в их системах искусственного интеллекта, особенно в отношении вопросов расы. Исследования показали, что технология распознавания лиц хуже работает в отношении "цветных" рас, что приводит к инцидентам, когда из-за ошибок распознавания чернокожие подвергаются дискриминации или их арестовывают.

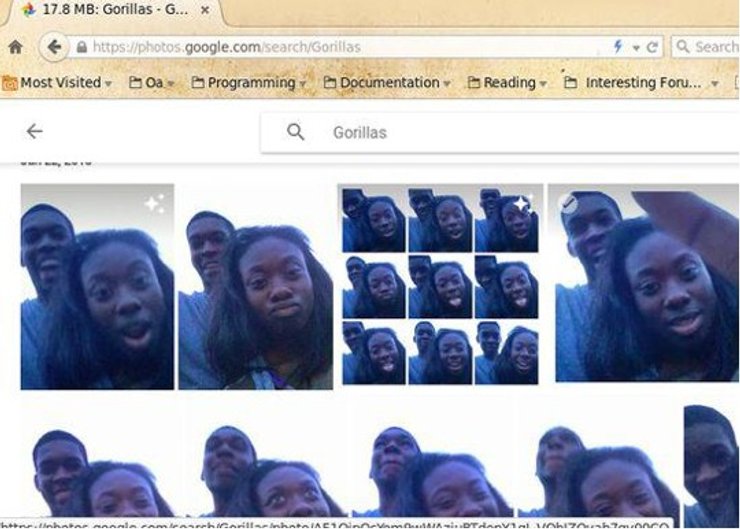

В 2015 году сервис Google Photos ошибочно пометил фотографии чернокожих людей как "гориллы". После этого в Google сказали, что "искренне сожалеют" и будут работать над немедленным решением проблемы.

Более чем через два года СМИ обнаружили, что решение Google заключалось в том, чтобы запретить слово "горилла" в поисковых запросах сервиса Photos, а также заблокировать слова "шимпанзе", и "мартышка". Как пояснила компания, ей пришлось пойти на такой шаг потому, что механизм распознавания изображений путал этих обезьян и представителей негроидной расы. Других обезьян он идентифицировал правильно.

Напомним, исследователи из Джорджтауна использовали текстовый генератор для написания вводящих в заблуждение твитов об изменении климата и международных отношений. Читатели посчитали эти сообщения убедительными.

Ранее Фокус сообщал, что президент Института будущего человечества (FLI) Макс Тегмарк развенчал три самых популярных мифа об искусственном интеллекте.