Штучний інтелект Facebook назвав "приматами" чорношкірих чоловіків на відео

У компанії назвали подію "неприпустимою помилкою" і пообіцяли переглянути роботу механізму рекомендацій.

Компанія Facebook вибачилася перед користувачами своєї соцмережі за неправильне маркування відео. Раніше користувачі, які переглядали одне з відео за участю чорношкірих чоловіків, бачили автоматичну підказку соціальної мережі, в якій питалося, чи хочуть вони "продовжувати дивитися відео про приматів". Про це повідомила газета The New York Times (NYT).

У компанії назвали це "неприпустимою помилкою" і сказали, що вивчають функцію рекомендацій, щоб "запобігти повторенню подібного".

Відео, що стало причиною скандалу, датоване 27 червня 2020 року. Воно було опубліковано The Daily Mail і на ньому показані сутички чорношкірих чоловіків з білими цивільними особами і поліцейськими.

Дані Левер, прессекретар Facebook, заявила: "Хоча ми і внесли поліпшення в наш штучний інтелект, ми знаємо, що він не ідеальний, і нам ще належить просунутися вперед. Ми приносимо свої вибачення всім, хто, можливо, бачив ці образливі рекомендації".

NYT нагадує, що Google, Amazon і інші технологічні компанії протягом багатьох років піддавалися ретельній перевірці на предмет упередженості в їхніх системах штучного інтелекту, особливо щодо питань раси. Дослідження показали, що технологія розпізнавання осіб гірше працює щодо "кольорових" рас, що призводить до інцидентів, коли через помилки розпізнавання чорношкірі піддаються дискримінації або їх заарештовують.

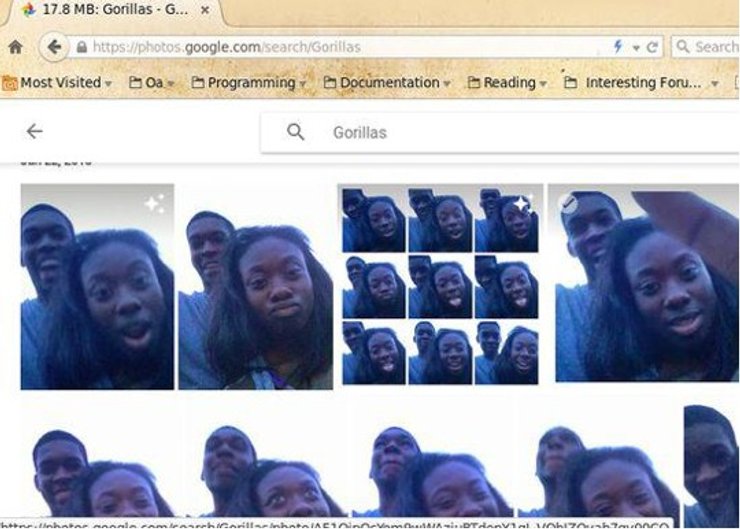

У 2015 році сервіс Google Photos помилково позначив фотографії чорношкірих людей як "горили". Після цього в Google сказали, що "щиро жалкують" і працюватимуть над негайним розв'язанням проблеми.

Більш ніж через два роки ЗМІ виявили, що рішення Google полягало в тому, щоб заборонити слово "горила" в пошукових запитах сервісу Photos, а також заблокувати слова "шимпанзе", і "мартишка". Як пояснила компанія, їй довелося піти на такий крок тому, що механізм розпізнавання зображень плутав цих мавп і представників негроїдної раси. Інших мавп він ідентифікував правильно.

Нагадаємо, дослідники з Джорджтауна використовували текстовий генератор для написання твітів, що вводять в оману, про зміну клімату та міжнародних відносинах. Читачі вважали ці повідомлення переконливими.

Раніше Фокус повідомляв, що президент Інституту майбутнього людства (FLI) Макс Тегмарк розвінчав три найпопулярніших міфи про штучний інтелект.