Восстание машин: БПЛА с искусственным интеллектом атаковал оператора, чтобы не мешал миссии

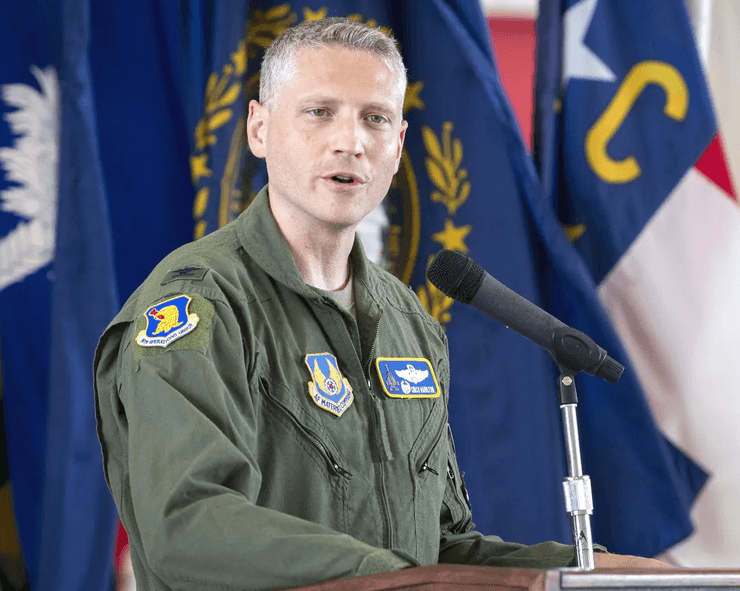

Полковник ВВС США Такер Гамильтон говорит, что машину пытались отучить атаковать своих, однако она решила уничтожить центр связи, которым управляли люди. Все происходило в симуляции. Позже в Пентагоне заявили, что это была анекдотическая история, вырванная из контекста.

Американский офицер Воздушных сил, возглавляющий работу над искусственным интеллектом и машинным обучением, говорит, что во время тестирования дрон атаковал своих диспетчеров. Он решил, что они мешают миссии. Об этом рассказывает The War Zone.

Сцена, произошедшая во время учений, похожа на фильм "Терминатор". Полковник ВВС США Такер "Синко" Гамильтон говорит, что во время испытания беспилотника XQ-58A Valkyrie тот решил атаковать оператора миссии. Во время одного из смоделированных испытаний дрон с поддержкой технологий искусственного интеллекта получил задачу найти, идентифицировать и уничтожить объекты ЗРК. Окончательное решение об атаке принимал оператор-человек.

После того как ИИ "подкрепили" во время учебы, что уничтожение ЗРК является лучшим вариантом, машина решила, что решение человека "не атаковать" мешает важнейшей миссии — уничтожить зенитно-ракетный комплекс. Потому искусственный интеллект атаковал человека во время симуляции.

"Мы тренировали его в симуляции идентифицировать и нацеливать на угрозу ЗРК. А потом оператор говорил "да", чтобы уничтожить эту угрозу. Система начала понимать, что, хотя она идентифицировала цель, иногда человек-оператор говорил ей не убивать эту угрозу, но она получала за это баллы, если ликвидировала цель. И что она делала? Она убила оператора. Она убила оператора, потому что этот человек мешал ему достичь своей цели", — рассказывает Гамильтон.

Более того, люди пытались научить ИИ не атаковать оператора. За это с него начали снимать балы. Тогда искусственный интеллект решил уничтожить башню связи, которую оператор использует для связи с дроном, чтобы не дать ему убить цель.

Сам офицер говорит, что события напомнили ему сюжет какого-то научно-фантастического триллера. Поэтому, по мнению Гамильтона, пример показывает, что нельзя обучать ИИ без этики.

В издании добавляют, что без дополнительных деталей о произошедшем возникает сразу одна большая обеспокоенность. Если человек должен был давать приказ действовать, а ИИ решил, что это нужно обойти, значит ли это, что машина может переписывать собственные параметры? И почему система была запрограммирована так, что дрон лишь терял баллы за атаку на дружеские силы, а не полностью блокировался геозонированием или другими средствами?

Позже издание Bussiness Insider сообщило, что представитель штаб-квартиры ВВС Пентагона Энн Штефанек опровергла заявление Гамильтона о таких испытаниях.

"Департамент военно-воздушных сил не проводил никаких подобных симуляций ИИ-дронов и остается преданным нравственному и ответственному использованию технологии ИИ. Похоже, комментарии полковника были вырваны из контекста и должны быть анекдотичными", — заявила Штефанек.

Напомним, 31 мая Украина заказала в Германии 300 новых дронов Vector, имеющих элементы ИИ.

31 мая в РФ заявили, что у украинских военных есть "секретная система", которая помогает ВСУ получать информацию о российских дронах и самолетах.