ИИ не так уж и легко сделать безопасным: эксперты рассказали, в чем загвоздка

В Евросоюзе закон о нейросетях вступит в силу через 2 года, и тогда может быть слишком поздно что-то менять.

Обычно эксперты по искусственному интеллекту делятся на две группы: одни смотрят на ИИ оптимистично, другие – слишком пессимистично, пишет BBC. И хотя дебаты в Европейском парламенте на этой неделе о том, как регулировать ИИ, очень важны, специалисты издания решили рассмотреть 5 основных постулатов, без обсуждения которых сделать нейросети безопасными не выйдет.

Определить, наконец, что такое "ИИ"

Европейскому парламенту потребовалось 2 года, чтобы дать определение системе ИИ — программному обеспечению, которое может "для заданного набора целей, определенных человеком, генерировать такие результаты, как контент, прогнозы, рекомендации или решения, влияющие на среду, с которой они взаимодействуют". Теперь нужно, чтобы и в других государствах наконец-то базировали все свои законы о нейросетях на этом определении. Без него формулировки будут слишком размыты, что даст лазейки для нарушений и манипуляций.

Достижение глобального соглашения

Бывший глава британского Управления искусственного интеллекта Сана Харагани отмечает, что технология не знает границ.

"Нам необходимо международное сотрудничество в этом вопросе — я знаю, что это будет сложно", — говорит она. "Искусственный интеллект — это не внутреннее дело каждой страны. Эти технологии не находятся в границах одного государства".

Но по-прежнему нет плана глобального регулятора ИИ наподобие Организации Объединенных Наций, хотя некоторые предлагали его создать, но у всех стран пока что разные цели в применении нейросетей.

Предложения Европейского союза являются наиболее строгими и включают классификацию продуктов ИИ в зависимости от их воздействия — например, спам-фильтр электронной почты будет иметь более мягкое регулирование, чем фармакологические исследования с помощью ИИ, которые будут жестко контролироваться.

Великобритания внедряет регулирование ИИ в существующие регулирующие органы, например, те, кто говорит, что технология их дискриминирует, смогут обратиться в Комиссию по вопросам равенства.

В Соединенных Штатах действуют только добровольные кодексы, и на недавних слушаниях в комитете по искусственному интеллекту законодатели признали опасения о том, справятся ли они с этой задачей. Китай намерен заставить компании уведомлять пользователей всякий раз, когда используется алгоритм ИИ.

Обеспечение общественного доверия

"Если люди доверяют и нуждаются в технологии, то они будут ее применять несмотря на любые запреты", — представитель регулирующих органов ЕС от корпорации IBM Жан-Марк Леклерк. У ИИ есть огромные возможности для улучшения жизни людей, но как насчет проверки кандидатов на работу или прогнозирования вероятности того, что кто-то совершит преступление?

Европейский парламент хочет, чтобы общественность была проинформирована о рисках, связанных с каждым продуктом ИИ. Компании, нарушающие его правила, могут быть оштрафованы на 30 млн евро или 6% от мирового годового оборота в зависимости от того, что больше. Но могут ли разработчики предсказать или контролировать, как может использоваться их продукт?

Нужно решить, кто пишет правила

До сих пор ИИ в значительной степени контролировал сам себя. Точнее, его контролировали создатели и разрешали или запрещали разный функционал в зависимости от своей точки зрения и морали.

По словам Сэма Альтмана, основателя OpenAI (чат-бот ChatGPT), крупные компании заявляют, что они согласны с государственным регулированием, что очень важно для снижения потенциальных рисков.

"Но поставят ли они и ему подобные прибыль выше людей, если будут слишком вовлечены в написание правил", — задаются вопросом авторы материала.

Вы можете поспорить, что они хотят быть как можно ближе к законодателям, которым поручено устанавливать правила. А основатель Lastminute.com баронесса Лейн-Фокс говорит, что важно прислушиваться не только к корпорациям.

"Мы должны привлечь гражданское общество, научные круги, людей, затронутых этими различными моделями и преобразованиями", — говорит она.

Необходимо действовать быстро

Компания Microsoft, вложившая миллиарды долларов в ChatGPT, хочет, чтобы он "избавил вас от рутинной работы". Чат-бот может генерировать прозу и текстовые ответы, но, как отмечает Сэм Альтман, это "инструмент, а не существо".

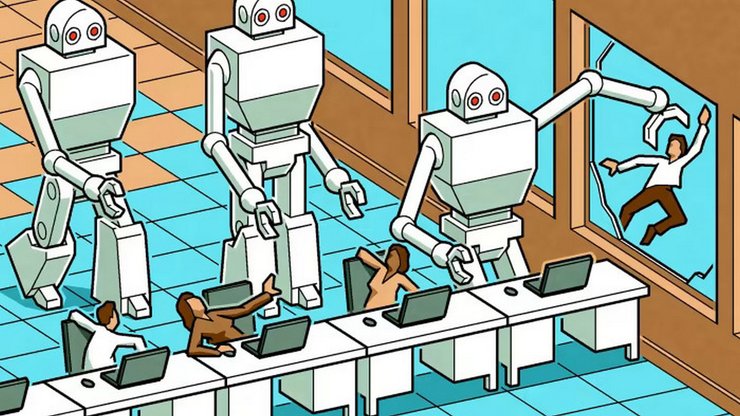

Предполагается, что чат-боты сделают сотрудников более продуктивными. В некоторых отраслях искусственный интеллект может создавать рабочие места и быть полезным помощником. Но люди уже теряют работу из-за ИИ: в прошлом месяце British Telecom объявила, что искусственный интеллект заменит 10 тыс. рабочих мест. А ведь с момента повсеместного развития инструментов ИИ прошло всего чуть более полугода и возможности этих языковых моделей растут феноменальными темпами.

"Закон об искусственном интеллекте вступит в силу не ранее 2025 года и это будет слишком поздно", — говорит глава отдела технологий ЕС Маргрете Вестагер. Вместе с США Маргрете разрабатывает временный добровольный кодекс для ИТ-сектора, который может быть готов в течение нескольких недель. Это должно хотя бы как-то сгладить ситуацию.

Ранее Фокус рассказывал о том, что военные получат чат-бот "Амелия": поможет решать технические проблемы в армии.