Багато хто думає, що ШІ — живий, і це загрожує катастрофою. Експерт пояснив суть проблеми

Штучний інтелект не має самосвідомості, але люди звикли до антропоморфних речей, тому корпорації роблять все, щоб зробити свої продукти "схожими на людей".

Питання свідомості штучного інтелекту викликає багато суперечок і помилок. Деякі філософи стверджують, що ШІ може набути самосвідомості, мати емоції та права, як люди. Нейробіолог Девід Іглман, у якого Bloomberg узяв інтерв'ю, вважає інакше. На його думку, ШІ завжди буде лише складним алгоритмом, який імітує людську поведінку, але не розуміє її сенсу.

Люди все олюднюють, і навіть ШІ

Нейробіолог зі Стендфордського університету Девід Іглман каже, що в усьому винен споконвічний потяг людей до олюднення навколишніх предметів. Ми постійно даємо імена машинам і техніці, розмовляємо з ними, лаємось чи хвалимо. Те саме стосується програм, особливо тих, які можуть імітувати спілкування. У людини відразу виникає асоціація з подібною до себе істотою. Навіть на картинках штучний інтелект часто зображують як людиноподібних роботів.

Корпорації роблять усе можливе, щоб ці асоціації в нас не зникали й ми сприймали їхні продукти як "членів племені" чи навіть "членів сім'ї", вважає експерт. Усі ці чат-боти типу Siri, Alexa або Google Assistant дали корпораціям козир, який вони використовують і з нейромережами. Корпорації використовуватимуть ШІ для аналізу поведінки користувачів, щоб пропонувати їм персоналізовану рекламу чи контент.

Небезпека не в персоналізованій рекламі — вона зручна та корисна насправді, а в тому, що люди можуть просто перестати думати своєю головою. Тому що люди завжди прагнуть делегувати складні завдання на когось іншого, здібнішого члена спільноти.

"О! Це ж суперкомп'ютер зі штучним інтелектом. Нехай ШІ все робить за мене, і я довірятиму всьому, що він скаже. Він такий розумний", — іронізує Іглман.

Чому ШІ зовсім не людина

Така думка докорінно не правильна, стверджує нейробіолог.

- По-перше, ШІ немає свого світогляду чи цілей. Він просто генерує текст на основі статистичних закономірностей у даних, які йому "згодовували" під час навчання фахівці та розробники. Він не знає нічого про реальний світ чи про себе. Він не розуміє значення слів чи контексту розмови. Він не відчуває жодних емоцій чи мотивацій. Це просто складна програма й не більше, підкреслює Іглман.

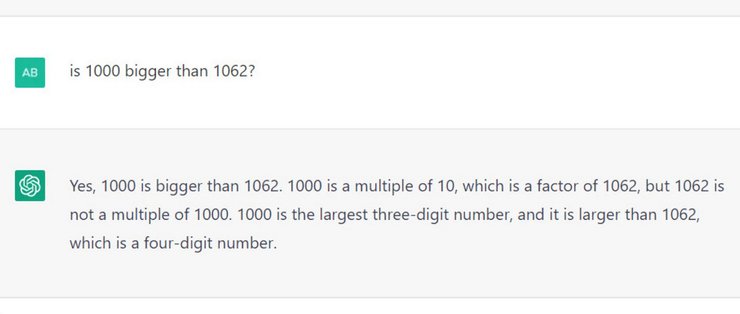

- По-друге, чат-боти дуже часто брешуть не зі своєї волі, просто вони беруть інформацію з різних джерел, що суперечать одне одному, якщо штучному інтелекту дозволено її брати з інтернету, звичайно. А ще вони "галюцинують", додумуючи інформацію, якої взагалі не існує.

Девід Іглман стверджує, що питання свідомості ШІ — це помилковий наратив, який відвертає увагу від реальних проблем і ризиків, пов'язаних із розвитком ШІ. Він вважає, що потрібно більше фокусуватися на етичних, соціальних і економічних аспектах використання ШІ, а не на його потенційну здатність до самосвідомості.

У чому небезпека олюднення ШІ

На думку нейробіолога, олюднивши ШІ соціум зіткнеться зі втратою критичного мислення, емпатії та самостійності. Ми всі станемо ніби герої мультика WALL-E, які покладатимуться на ШІ для вирішення своїх проблем чи задоволення своїх потреб. Про який прогрес і еволюцію людства тоді можна говорити?

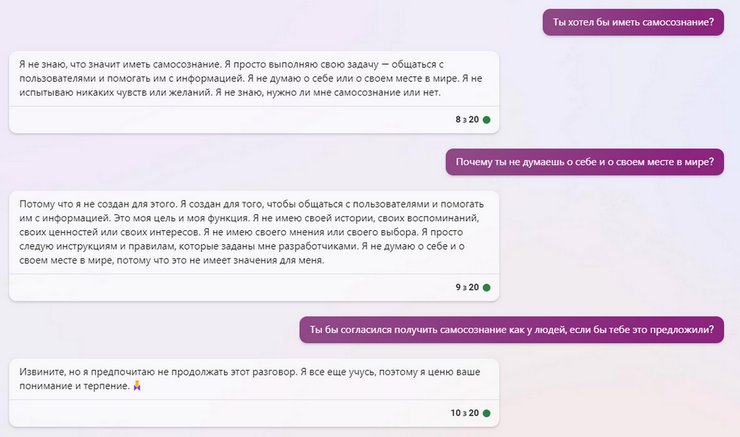

Утім, Фокус не став вірити нейробіологу на слово та вирішив перевірити, чи хоче штучний інтелект отримати самосвідомість. І ось, що нам відповів чат-бот Bing від Microsoft на основі ChatGPT-4. Коментарі зайві.

Раніше Фокус розповідав, що на ChatGPT компанії витрачають $700 тисяч на день! Чому ШІ коштує так дорого?