У ЄС б'ють на сполох: експерти дізналися, як штучний інтелект може вплинути на вибори

За словами фахівців ENISA, європейці готуються ухвалити Закон про ШІ, але досі незрозуміло, як боротися з генеративними моделями і діпфейками.

Агентство Євросоюзу з кібербезпеки ENISA (ETL) попередило, що нові потужні моделі штучного інтелекту (ШІ) можуть стати руйнівним чинником на виборах у ЄС у червні 2024 року. Про це 19 жовтня повідомляє загальноєвропейська новинна платформа Euractiv.

"Довіра до виборчого процесу ЄС буде критично залежати від нашої здатності покладатися на кібербезпечні інфраструктури, а також від цілісності та доступності інформації. Тепер від нас залежить, чи застосуємо ми необхідні дії для досягнення цієї чутливої, але важливої мети для наших демократій", — заявив виконавчий директор ENISA Юхан Лепассаар.

Як зазначають фахівці, моделі штучного інтелекту особливо актуальні для так званої соціальної інженерії, тобто психологічних маніпуляцій. Це відбувається завдяки здатності ШІ створювати текст, нібито написаний людиною, або достовірно схожі зображення та відео, які замінюють схожість однієї людини на іншу — діпфейки.

У звіті ENISA зазначено, пише портал, що з моменту публічного випуску ChatGPT (практично з листопада 2022 року. — Ред.) штучний інтелект став основним драйвером інновацій в імітації текстів як законних джерел, клонуванні голосів та інтелектуальному аналізі даних за допомогою ШІ.

"У такий спосіб зловмисники можуть використовувати їх для проведення великомасштабних кампаній із маніпулювання інформацією", — підкреслює агентство.

Чат-боти на базі штучного інтелекту, як-от ChatGPT від OpenAI і Bard від Google, на думку експертів видання, також можуть піддаватися маніпуляціям із наборами даних, наприклад, щоб зіпсувати імідж бізнес- або політичному конкуренту.

На початку весни цього року Euractiv повідомив, що інше агентство ЄС — Європол, що відповідає за правоохоронну діяльність, вказало на потенційне злочинне використання генеративних систем штучного інтелекту, як-от ChatGPT, для онлайн-шахрайства та інших кіберзлочинів.

"Тенденція передбачає, що генеративний ШІ надає можливість суб'єктам загроз створювати складні та цілеспрямовані атаки з високою швидкістю і масштабом. Ми очікуємо більш цілеспрямованих атак соціальної інженерії із використанням технологій на основі ШІ в майбутньому", — підсумувало ENISA.

Тим часом у ЄС завершується робота над Законом про штучний інтелект — першою у світі всеосяжною постановою в цій сфері. Однак те, як боротися з генеративним штучним інтелектом і діпфейками, все ще залишається відкритою дискусією, підкреслює Euractiv.

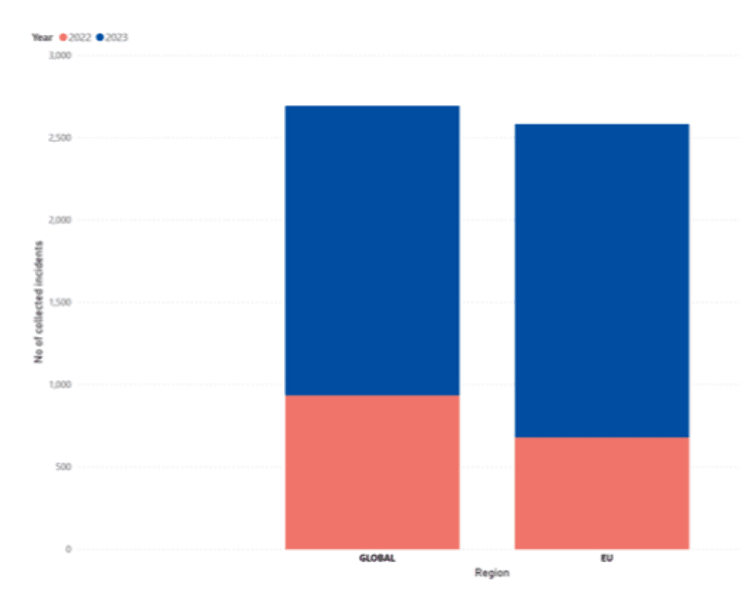

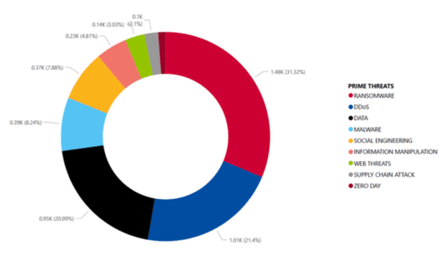

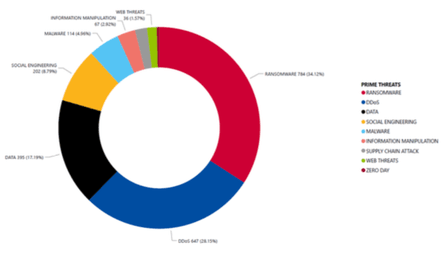

"Планета загроз 2023 року" — що відомо

Сьогоднішнє попередження агентства ENISA є частиною їхнього щорічного звіту про стан поля загроз кібербезпеки під назвою "Планета загроз". У центрі уваги цього звіту фахівці агентства бачать можливі збої, пов'язані з чат-ботами з ШІ, як-от відомий ChatGPT, і будь-які форми маніпулювання інформацією за допомогою штучного інтелекту.

Водночас, як зауважує Euractiv, нові моделі штучного інтелекту, для яких характерна підвищена потужність, можуть бути використані для зриву виборчих процесів не тільки в Європі.

"У зв'язку з наближенням виборів у США і Великій Британії експерти попереджають про ризик того, що зображення або відео, створені ШІ, стануть вірусними, а також про пропагандистських ботів, які працюють на базі ШІ", — нагадує портал про статтю в Guardian.

Важливо

Раніше Фокус писав, що Держдепартамент США розробив декларацію про відповідальне військове використання ШІ. Американські політики побоюються, що впровадження таких технологій можуть призвести до загибелі всього людства, а ось Росія, Китай, США та Ізраїль поки не дуже хочуть обмежувати їх застосування в системах озброєння.

Також Фокус інформував, що штучний інтелект навчився планувати біологічні атаки.

Раніше Фокус розповідав, що вчені збираються перетворити ШІ на гурмана і сомельє. Без почуття смаку ШІ не може зрозуміти людей, стверджують фахівці, а значить потрібно навчити штучний інтелект відчувати всі емоції людини від їжі.