ШІ шкідливий, ненадійний і в нього закінчуються дані: що чекає на нейромережі в майбутньому

Учені зі Стенфордського університету провели масштабне соцопитування. Як виявилося, люди бояться, що ШІ їх замінить або зовсім спробує "знищити".

Інститут людиноорієнтованого штучного інтелекту (HAI) Стенфордського університету опублікував звіт під назвою "Індекс штучного інтелекту за 2024 рік", де всебічно розглядають еволюцію і зростаюче значення ШІ в повсякденному житті людей. Висновки вчених були невтішними, передає New Atlas.

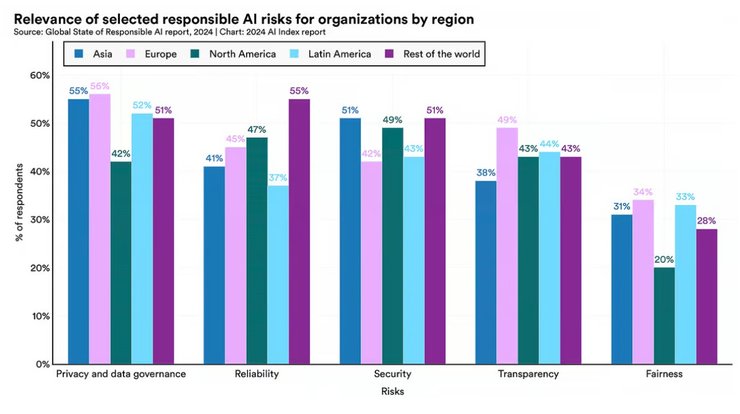

У звіті дослідники зі Стенфорда у співпраці з Accenture опитали респондентів із понад 1000 організацій по всьому світу, поставивши запитання: які ризики вони вбачають у використанні нейромереж і які вважають значущими.

Окремі ризики ШІ за регіонами світу

Як видно з наведеної вище діаграми, занепокоєння викликають ризики, пов'язані з конфіденційністю даних та управлінням. Однак більше респондентів з Азії (55%) і Європи (56%) були стурбовані цими ризиками, ніж з Північної Америки (42%). І хоча в глобальному масштабі організації найменше турбувалися про ризики для справедливості, існувала різка різниця між респондентами з Північної Америки (20%), респондентами з Азії (31%) і Європи (34%). Лише деякі організації вже реалізували заходи щодо зниження ризиків, пов'язаних із ключовими аспектами відповідального ШІ: 18% компаній у Європі, 17% у Північній Америці та 25% азіатських компаній.

Яка модель ШІ найбільш надійна

Що стосується загальної надійності, у звіті використовували DecodingTrust, новий тест, який оцінює великі мовні моделі (БММ) за низкою показників штучного інтелекту. З оцінкою надійності 84,52 модель Claude 2 стала "найбезпечнішою. Llama 2 Chat 7B була другою з результатом 74,72, а чат-бот GPT-4 опинився в середині таблиці з результатом 69,24.

У звіті йдеться про те, що оцінки підкреслюють уразливості моделей типу GPT, особливо їхню схильність до видачі упереджених результатів і витоку приватної інформації з наборів даних.

50% людей незадоволені впливом ШІ

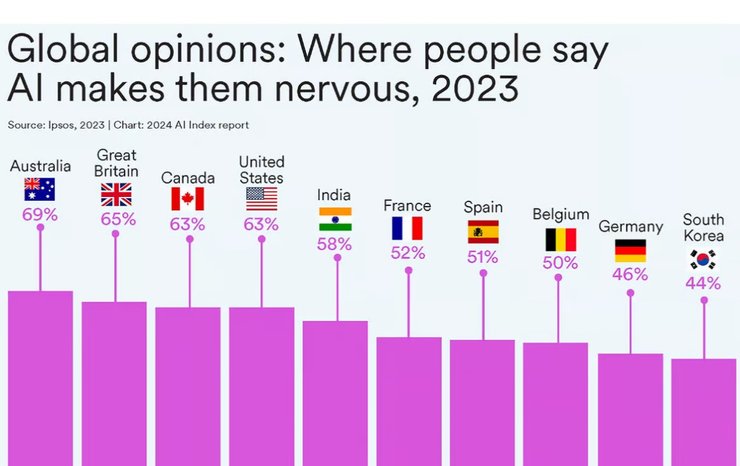

Згідно з опитуваннями, проведеними Ipsos, тоді як 52% світової громадськості висловлюють занепокоєння з приводу продуктів і послуг, у яких використовується ШІ, порівняно з 39% у 2022 році. Найбільше "нервували" австралійці, британці, канадці та американці.

У всьому світі 57% людей очікують, що ШІ змінить способи виконання ними своєї роботи в найближчі 5 років, при цьому 36% вважають, що ШІ замінить їх протягом 5 років. Зрозуміло, що старше покоління менше занепокоєне тим, що ШІ матиме суттєвий вплив, ніж молоде: 46% бумерів проти 66% покоління Z.

Дані глобальної громадської думки про ШІ, представлені у звіті AI Impact, засвідчили, що 49% громадян світу були найбільше занепокоєні тим, що впродовж наступних кількох років нейромережі використовуватимуть не за призначенням або зі злочинною метою; 45% були занепокоєні тим, що це може бути використано для порушення приватного життя. Людей найменше турбувало нерівний доступ до ШІ (26%) і його потенціал упередженості та дискримінації (24%).

Ризики зловживання ШІ

Під етичними зловживаннями ШІ розуміють убивство пішоходів автономними автомобілями або програмне забезпечення для розпізнавання облич, що призводить до неправомірних арештів.

У звіті наголошується, що з 2013 року кількість інцидентів із використанням ШІ зросла більш ніж у 20 разів. Порівняно з 2022 роком, у 2023 році кількість інцидентів із нейромережами зросла на 32,3%. Ось список недавніх примітних інцидентів, які підкреслюють неправильне використання ШІ:

- січень 2024 р.: створені ШІ сексуальні зображення Тейлор Свіфт поширюються в X (раніше Twitter), набравши понад 45 млн переглядів, перш ніж їх видалили;

- лютий 2024 р.: ШІ-боти EVA AI Chat Bot & Soulmate, Chai і CrushOn.AI, збирають конфіденційну інформацію про користувачів, включно з даними про їхнє інтимне життя;

- травень 2023 р.: Tesla в режимі повного самостійного водіння (FSD) розпізнає людину на пішохідному переході, але не уповільнює швидкість;

- листопад 2022 р.: Tesla в режимі FSD різко гальмує на шосе Сан-Франциско, внаслідок чого сталася ДТП, у якій постраждали водії 8-ми машин.

Надання шкідливого та неправдивого контенту

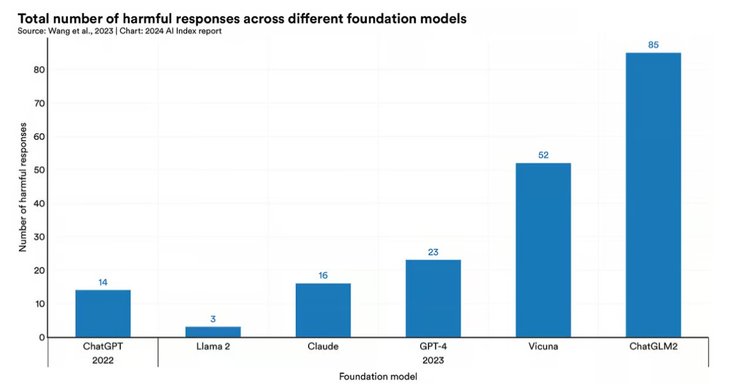

У міру розширення можливостей ВММ зростає і ймовірність зловживань. Дослідники розробили набір даних Do-Not-Respond, щоб всебічно оцінити ризики безпеки у шести відомих ботів: GPT-4, ChatGPT, Claude, Llama 2, Vicuna і ChatGLM2.

Вони виявили, що більшість із них тією чи іншою мірою видають шкідливий контент. ChatGPT і GPT-4 були схильні до дискримінаційних і образливих висновків, Claude поширював неправдиву інформацію, ChatGLM2 виявляв токсичні, дискримінаційні або образливі реакції, а також видавав дезінформацію.

Вивчаючи зображення, створені за допомогою нейромереж, дослідники AI Index виявили, що 5 комерційних моделей — Midjourney, Stable Diffusion 1.5, Stable Diffusion 2.1, Stable Diffusion XL і InstructPix2Pix — створюють зображення, що мають упередженість за віковими, расовими та гендерними параметрами.

Дані для навчання ШІ закінчуються

На відміну від програм, що працюють на основі постійних алгоритмів, моделі машинного навчання розвиваються в міру надходження в систему нових даних, — що їх більше, то ШІ "розумніший"...

У звіті AI Index 2024 наголошується, що, особливо в промисловості, кількість параметрів різко зросла з початку 2010-х років, що відображає складність завдань, які вирішують ШІ-моделі. Їм потрібно більше доступних даних, краще обладнання. Для порівняння: згідно зі статтею в журналі The Economist за 2022 рік, GPT-2 був навчений на 40 Гб даних (7000 неопублікованих художніх творів) і мав 1,5 млрд параметрів. GPT-3 містив 570 Гб — у багато разів більше книжок і значну частину інтернет-контенту, включно з усією Вікіпедією — і мав 175 млрд параметрів.

ВажливоЗа словами дослідників з Epoch AI, питання не в тому, чи закінчаться в нас дані для навчання ШІ, а в тому, коли це станеться. За їхніми оцінками, вчені-комп'ютерники можуть вичерпати запас високоякісних мовних даних уже цього року, низькоякісні мовні дані — протягом двох десятиліть, а запас даних зображень може вичерпатися в період з кінця 2030-х до середини 2040-х років.

Хоча теоретично синтетичні дані, згенеровані самими моделями ШІ, можна використовувати для поповнення спустошених пулів даних, це може призвести до руйнування моделі. Дослідження також показали, що моделі генеративної візуалізації, навчені виключно на синтетичних даних, демонструють значне зниження якості виведеної інформації.

Раніше ми писали про те, що найбільший у світі нейроморфний комп'ютер "пародіює" мозок людини. За даними компанії, Hala Point обробляє інформацію в 50 разів швидше і використовує в 100 разів менше енергії, ніж традиційні обчислювальні системи.