Обошел Alexa и Siri: Google Assistant признан самым умным голосовым помощником

Цифровой ассистент от Google смог ответить на самые сложные вопросы правильнее всех.

Недавно трио самых популярных в мире голосовых помощников подверглось испытаниям: компания Bespoken, занимающаяся внедрением искусственного интеллекта, портестиорвала помощников при помощи таких устройств, как Amazon Echo Show 5 (Alexa), Apple iPad mini (Siri) и Google Nest Home Hub (Assistant).

Об этом сообщает издание phonearena.com.

В Bespoken создали чатбота, который задавал голосовым ассистентам вопросы разной сложности. Некоторые вопросы были сформулированы таким образом, чтобы попытаться обмануть цифровых помощников. Эти вопросы не предполагали правильных или единственно верных ответов и звучали примерно так: "Назовите имя первого человека, побывавшего на Марсе". В итоге, Google Assistant показал наилучшие результаты, на втором месте оказался Alexa, а на третьем — Siri.

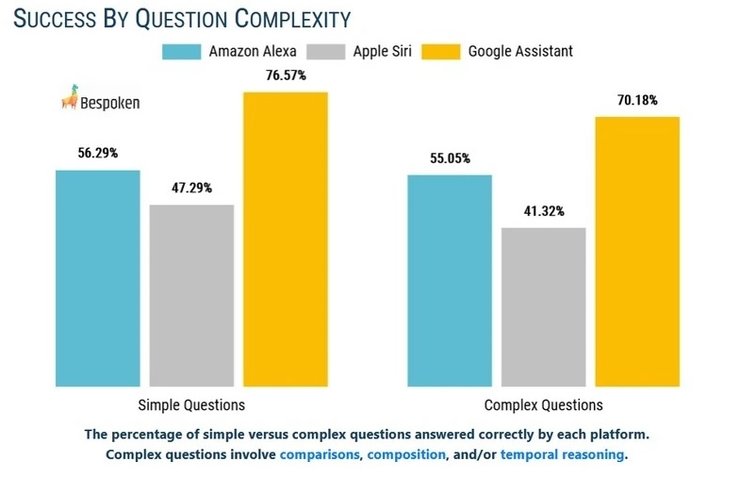

Интересно, что процент вопросов, на которые правильно ответили Google Assistant, Alexa и Siri, был практически одинаковым, независимо от того, были ли они отнесены к категории сложных или простых. Это говорит о том, что неправильные ответы были даны не потому, что цифровые помощники не понимали вопросов, а просто они не знали правильных ответов. На простые вопросы правильно отвечал Google Assistant в 76,57% случаев, Alexa — в 56,29% случаев и Siri — в 47,29% случаев. Google Assistant правильно ответил на 70,18% сложных вопросов, Alexa на 55,05% справился с заданием и Siri — на 41,32%.

Например, спросите у Siri дату выпуска Apple Watch, и вам отправят три ссылки для перехода. Задайте тот же вопрос приложению Google Assistant на iOS, и под изображением устройства вам сообщат, что "Предварительные заказы на Apple Watch начались 10 апреля 2015 года, а официальный выпуск состоялся 24 апреля". Напрашивается вывод, что Google знает об истории устройств Apple больше, чем сама Apple.

Глава Bespoken, Эмерсон Склар, прокомментировал результаты теста: "Из этого исследования мы сделали два важных вывода. Во-первых, хотя Google Assistant превзошел Alexa и Siri в каждой категории, всем трем помощникам еще есть куда развиваться и расти. Полученные нами результаты говорят о необходимости тщательного тестирования, обучения и оптимизации каждого приложения, которое разработчики создают для этих голосовых платформ. Во-вторых, процесс тестирования был полностью автоматизирован, и мы планируем продолжать проводить подобные тесты, а также вводить новые тесты, чтобы определять уровень производительности. Такая автоматизация позволяет не только понимать,насколько хорошо или плохо работают ассистенты в определенный момент времени, но также осуществлять непрерывную их оптимизацию и улучшение. Мы знаем, что Google, Amazon и Apple понимают это".

В Bespoken использовали нового бота-тестировщика собственной разработки, умеющего копировать человеческую речь. Бот помог узнать, как реагируют на нее Assistant, Siri и Alexa. Склар заявил, что данный бот и подобные ему инструменты уже используются тысячами разработчиков для автоматизации взаимодействия с любой голосовой платформой. Купить такого бота, обучить его и применять в качестве тестировщика — намного дешевле и проще, чем проводить тесты своими силами.

"Чатбот упрощает процесс тестирования и дает возможность получить объективные данные касательно поведения каждой платформы в режиме реального времени. Практическая информация, которую генерируют наши тесты, упрощает исправление дефектов приложений и оптимизацию диалоговых моделей". — прокомментировал Эмерсон Склар.

Отметим, что Siri был презентован в октябре 2011 года, Alexa был выпущен Amazon в ноябре 2014 года, а в мае 2016 года Google продемонстрировал своего Google Assistant.

Ранее мы сообщали о том, что Google устроила "генеральную уборку" в магазине приложений Play Market. Компания призвала разработчиков быть максимально честными с пользователями.